Neuro-Symbolische KI: Die Stärken von zwei Welten vereint

Von Marcel Blattner, Juni 12, 2024

Die Kombination von symbolischen und konnektionistischen Methoden kann ein Weg zu besseren und robusteren KI-Systemen sein.

Die Geschichte der Künstlichen Intelligenz (KI) reicht bis in die Mitte des 20. Jahrhunderts zurück[1]. In dieser Zeit entstand die erste Welle der KI-Forschung, welche durch symbolische Ansätze getragen wurde. Symbolische Methoden sind durch regelbasierte Systeme und Logik gekennzeichnet. Forscher wie Allen Newell und Herbert A. Simon leisteten einen bedeutenden Beitrag in diesem Feld und schufen den Logic Theorist[2], der oft als erstes KI-Programm betrachtet wird. Diese und weitere Entwicklungen führten zu Expertensystemen, die in der Lage waren, Entscheidungen in bestimmten Bereichen zu treffen aufgrund des definierten Regelwerkes. Die Stärken dieser Methoden liegen in der Transparenz und Stabilität der verwendeten Algorithmen. Ein Nachteil ist, dass diese Methoden nicht sehr gut skalieren.

Im späten 20. und frühen 21. Jahrhundert nahm die Forschung der Künstlichen Intelligenz erneut Fahrt auf. Diese Phase war durch statistische und konnektionistische Methoden[3] gekennzeichnet. Dieser Ansatz konzentrierte sich auf das Lernen aus Daten und nicht auf die Verwendung vordefinierter Regeln. Das war die Geburtsstunde des maschinellen Lernens und später des Deep Learning. KI-Systeme konnten nun riesige Datenmengen analysieren, Muster erkennen und Entscheidungen treffen; alles ohne explizite Programmierung für jede spezifische Aufgabe. Diese konnektionistischen KI-Systeme, inspiriert von den biologischen neuronalen Netzwerken im menschlichen Gehirn[4], erzielen bemerkenswerte Erfolge in vielen Bereichen wie Bilderkennung und der Verarbeitung von natürlicher Sprache. Der konnektionistische Ansatz kulminiert in die grossen Sprachmodelle – Transformer basierte neuronale Netze wie z.B. GPT-4. Die Stärken dieser Methoden liegen in der Flexibilität und Skalierbarkeit. Der Nachteil besteht darin, dass sie schwer durchschaubar sind, wie sie zu einem bestimmten Ergebnis kommen. Die grundlegenden Unterschiede der beiden Ansätze sind folgend dargestellt.

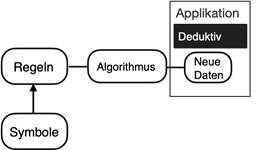

Symbolischer Ansatz

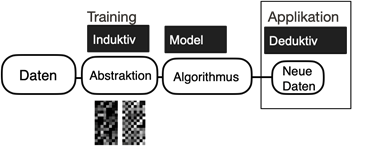

Konnektionistischer Ansatz

Symbolischer Ansatz: Algorithmen werden über Symbole und eine Menge von Regeln definiert. Symbole haben eindeutige Eigenschaften.

Konnektionistischer Ansatz: Algorithmen definieren sich über die Abstraktion von gefundenen Zusammenhängen in den Daten.

In der heutigen Zeit erforschen Wissenschaftler die Verschmelzung der beiden Welten, was zur Geburt des Neuro-Symbolischen (NeSy-KI)[5] Ansatzes führt. Dieser Ansatz zielt darauf ab, die Stärken sowohl des symbolischen als auch der konnektionistischen Methoden zu kombinieren, um KI-Systeme zu schaffen, die aus Rohdaten lernen (neuronal) und mit stabilen Abstraktionen Erklärungen liefern können (symbolisch). Nehmen wir ein Beispiel aus dem medizinischen Bereich: Diagnosen von Krankheiten anhand von MRI-Scans, welche durch KI basierte Systeme analysiert werden. Ein neuronales Netz (konnektionistischer Ansatz) wird anhand von tausenden MRI-Scans trainiert, um Tumore zu identifizieren. Dieses System kann eine sehr hohe Genauigkeit bei der Identifikation erreichen.

Wenn das System einen Tumor diagnostiziert hat, kann es aber keine Erklärung oder Begründung liefern, wie die Klassifizierung zu Stande kam (Black-Box).

Wenn man dieses System durch eine symbolisch basierte Abstraktions-Ebene erweitert, kann man sicherstellen, dass neben den analysierten Bildern und deren Klassifikationen auch entsprechende Erklärungen (warum wurde ein Tumor diagnostiziert) mitgeliefert werden.

Der symbolische Layer kann zum Beispiel auf den Richtlinien basieren, die Radiologen zur Interpretation von MRI-Scans verwenden, wie die Angabe der Grösse, Lage und Formmerkmale des Tumors. Auf diese Weise kann das NeSy-KI-System die Leistungsfähigkeit neuronaler Netze nutzen, um genaue Diagnosen zu stellen, während es gleichzeitig verständliche Erklärungen liefert für seine Entscheidungen[6].

Es muss betont werden, dass der Mensch (noch) eine unersetzliche Rolle bei der Überprüfung der Diagnose-Ergebnisse spielt. Systeme der geschilderten Art sind als Komplement zu menschlichem Fachwissen zu verstehen und nicht als Ersatz geeignet!

Die Anwendungsgebiete von KI-Systemen, welche die EU als hochriskant einstuft, sind besonders gut geeignet für NeSy-KI-Systeme, da sie die nötige Rechtfertigung liefern, warum ein System einen bestimmten Output generiert.

Fussnoten:

[1] Der Begriff «Künstliche Intelligenz» wurde an der Dartmouth Konferenz 1956 geboren. Die Konferenz wurde in New Hampshire durchgeführt. Organisiert und geplant wurde sie unter anderem von John McCarthy, der sich dafür stark machte, dass man das neue Forschungsfeld als Künstliche Intelligenz bezeichnet. [2] Gugerty, L., 2006, October. Newell and Simon’s logic theorist: Historical background and impact on cognitive modeling. In Proceedings of the human factors and ergonomics society annual meeting (Vol. 50, No. 9, pp. 880-884). Sage CA: Los Angeles, CA: SAGE Publications. [3] Neuronale Netze gehören dieser Kategorie an – und damit auch alle Large Language Modelle wie GPT-4. [4] Es muss angemerkt werden, dass es bei der Inspiration bleibt. Künstliche “Neuronen” haben wenig bis gar keine Ähnlichkeit mit dem biologischen Vorbild. [5] Neuro steht für konnektionistisch. [6] Gulum, M.A., Trombley, C.M. and Kantardzic, M., 2021. A review of explainable deep learning cancer detection models in medical imaging. Applied Sciences, 11(10), p.4573.

Quelle: eigene Aufnahme

Marcel Blattner

Dr. Marcel Blattner ist promovierter Physiker und ein leidenschaftlicher Daten-Surfer. Er doziert an der HWZ zu Themen wie Künstliche Intelligenz und Quantum Computing.

My World

Unser Newsletter liefert dir brandaktuelle News, Insights aus unseren Studiengängen, inspirierende Tech- & Business-Events und spannende Job- und Projektausschreibungen, die die digitale Welt bewegen.