Die letzten US-Präsidentschaftswahlen 2016 hatten zur Folge, dass der Begriff «Hacking» eine neue Bedeutung erhielt. Adrienne Fichter ist Politologin und Redakteurin beim Online-Magazin Republik. Im Modul «Smartphone-Demokratie» vom 13.12.2019 vermittelt sie auf eindrückliche Weise, wie wir heutzutage politische Debatten auf den sozialen Medien führen. Ihr Ziel: Die Chancen und Gefahren der digitalen politischen Meinungsbildung verstehen.

Neue Dimension des Begriffs «Hacking»

Mit dem Begriff Hacking werden oft kriminelle Computer-Nerds assoziiert, die Systeme lahmlegen und Geld erpressen. Doch der Begriff bedeutet weitaus mehr. Das wurde uns allen auch nach den letzten US-Präsidentschaftswahlen bewusst, wo gezielt falsche Profile im Umlauf waren, um haufenweise Desinformationen zu den Wahlen und Kandidaten zu streuen.

Adrienne Fichter definiert Hacking in ihrer Vorlesung folgendermassen:

Hacking = Desinformation und Propaganda, also Mind-Hacking.

Die Utopie der Agora

Zu Beginn der Social Media Ära herrschte die Illusion der digitalen Agora. Die Agora war im antiken Griechenland der zentrale Fest- und Versammlungsplatz, eine bedeutende gesellschaftliche Institution. Ebenso wie damals sollten die sozialen Medien die Vernetzung der Menschen fördern. Gemeinsam digital kommunizieren, gemeinsam Gutes tun. Jeder hat eine Stimme, Hierarchien werden aufgehoben! Leider funktioniert das nicht. Denn die sozialen Medien katalysieren. Technik ist nicht neutral. Sie wurde von Menschen erschaffen. Die Plattformen weisen Verhaltensmuster auf.

«Gibt man jedem eine Stimme, sind die Arschlöcher die Lautesten»

Joi Ito, MIT Media Lab

Adrienne Fichter verfolgt einen soziotechnischen Ansatz und beleuchtet, wie die Social Media Plattformen und deren Algorithmen funktionieren. Ebenso befasst sie sich mit den Designs der Plattformen und den verschiedenen Geschäftsmodellen. Denn all diese Punkte prägen die Art, wie wir über politische Themen diskutieren, als auch wie wir uns im Netz informieren.

Mobilisation oder Manipulation – ein geschichtlicher Facebook Diskurs

Facebook hat seit 2011 bis heute die Demokratie massgeblich belebt. So hat Facebook als Katalysator für den arabischen Frühling (2011) gewirkt sowie Massen für den Women’s March (2017) und die Klimastreiks (2019) mobilisiert.

Adrienne Fichter zeigt anhand eines Kurzabriss der Geschichte von Facebook auf, welche Auswirkungen soziotechnische Aspekte haben können.

Wachstum über Allem

2012 war Facebook ein soziales Netzwerk und Protesttool, welches als Start-up noch kein Geld verdiente. Facebook verfolgte das Ziel, mit mehr Profilen zu wachsen. Mark Zuckerberg, Facebook-Gründer, entscheidet sich, am 17. Mai 2012 an die Börse zu gehen. Ein Jahr später verkündet er das neue Ziel, «die personalisierte Zeitung für jedermann» zu werden.

Somit leitete Facebook eine regelrechte «Medienrevolution» ein. Neu bevorzugte der Facebook Algorithmus als «Medienseiten» registrierte Facebook-Profile. Medienportale wie «BuzzFeed» optimierten ihre Inhalte so, dass sie aufgrund des algorithmischen Vorteils sich möglichst schnell verbreiteten. So holten sie bis zu 80% des Traffics aus den Sozialen Medien. Die Auswirkung: Facebook profitierte, da die Nachrichten der bekannten Medien die Plattform interessanter machten. Die Medienhäuser gewannen an Reichweite, hatten jedoch praktisch keine monetären Vorteile. Und der Algorithmus förderte die Verbreitung von Unwahrheiten. Denn der Algorithmus verbreitete die Nachrichten aufgrund der emotionalen Reaktionen, die diese auslösten. Er reagierte auf Wut und Hass und läutete somit die Zeit der Fake News ein.

Das Jahr der Wahlen

2016 baute Facebook das Kampagnenangebot für Parteien und Politiker aus. Nach den US-Präsidentschaftswahlen standen Facebook und sein Algorithmus in der Kritik. Beispielsweise registrierten sich die «Liberty News Writer» als Medienhaus und fanden heraus, dass Trump Posts besser funktionierten. Sie nutzten gezielt Desinformationen, um Geld zu verdienen. Ebenso performten Fake News unmittelbar vor den Wahlen besser im Facebook Newsfeed. Daraufhin reagierte Facebook und änderte 2017 seinen Algorithmus. Inhalte von Freunden gewichten neu stärker. Die Reichweite der Medienhäuser sackte daraufhin deutlich ab.

Für detailliertere Ausführungen zur Geschichte Facebooks und Zuckerbergs-Manipulationsmaschine ist hier zu lesen.

Auswirkungen von Filter Bubbles, Micro-Targeting, Bots und Co. auf unsere Meinungsbildung

Im Weiteren beleuchtet Adrienne Fichter verschiedene Aspekte auf den sozialen Medien, welche unsere Meinungsbildung beeinflussen.

Fake News

Als echte Nachrichten getarnt werden Falschmeldungen gezielt verbreitet und die Wahrnehmung des Lesers somit beeinflusst. In Deutschland gibt es bereits ein Gesetz, welches Facebook und Twitter zwingt Fake News zu löschen.

Filterblasen

Das sogenannte Filter-Bubble-Phänomen bedeutet, dass Nutzerinnen und Nutzer auf den Sozialen Medien personalisierte Informationen dargeboten erhalten. Wie im realen Leben umgeben wir uns auch auf den sozialen Medien mit Menschen, die gleiche Meinungen und Einstellungen mit uns teilen. Somit posten unsere Freunde wahrscheinlich auch eher Mitteilungen und Artikel, die ihrer Meinung entsprechen. So könnte durchaus der Eindruck entstehen, dass die eigene Ansicht von der Mehrheit der Menschen geteilt wird. Dadurch wird die eigene Meinung bestärkt. Die Algorithmen der verschiedenen Plattformen unterstützen dieses Phänomen, denn Engagement wird belohnt.

Micro-Targeting

Micro Targeting ist für Facebook ein Geschäftsmodell, für die Werbeschaffenden ein Segen. Mit Micro-Targeting kann die Zielgruppe personalisiert angesprochen werden. Damit lässt sich mit wenig Streuverlust effizient werben. Hört sich sehr verlockend an, doch was genau passiert mit den Daten? Wie gehen die Plattformen damit um? Wie sicher sind die Daten bei den Plattform-Anbietern? Der Fall Cambridge Analytica zeigte, dass im grossen Stil auch illegal Daten beschafft werden können und zwar ohne Wissen der Nutzer. Cambridge Analytica nutzte das Micro-Targeting gezielt im Wahlkampf, um mit personalisierter Werbung Meinungen zu beeinflussen.

Dark Ads

Dark Ads sind Anzeigen, die nicht öffentlich sichtbar sind, sondern nur einer gezielten Gruppe von Facebook-Nutzern gezeigt werden. Mit Hilfe von Kriterien kann die Zielgruppe genau eingeschränkt werden. Die Dark Ads werden auch für politische Themen und für individualisierte Wahlversprechen eingesetzt. Problematisch ist, dass Medienschaffende nicht mehr nachvollziehen können, wie die politischen Kampagnen aussehen. Es besteht zudem keine Möglichkeit, Fake News und gezielte Desinformation zu ahnden. Hetzkampagnen bleiben im Versteckten und können nicht mehr ans Tageslicht gebracht werden. Adrienne Fichter fordert daher ein öffentliches Werbearchiv für Parteien, damit die Werbekampagnen nachverfolgt werden können.

«Messengerisierung»

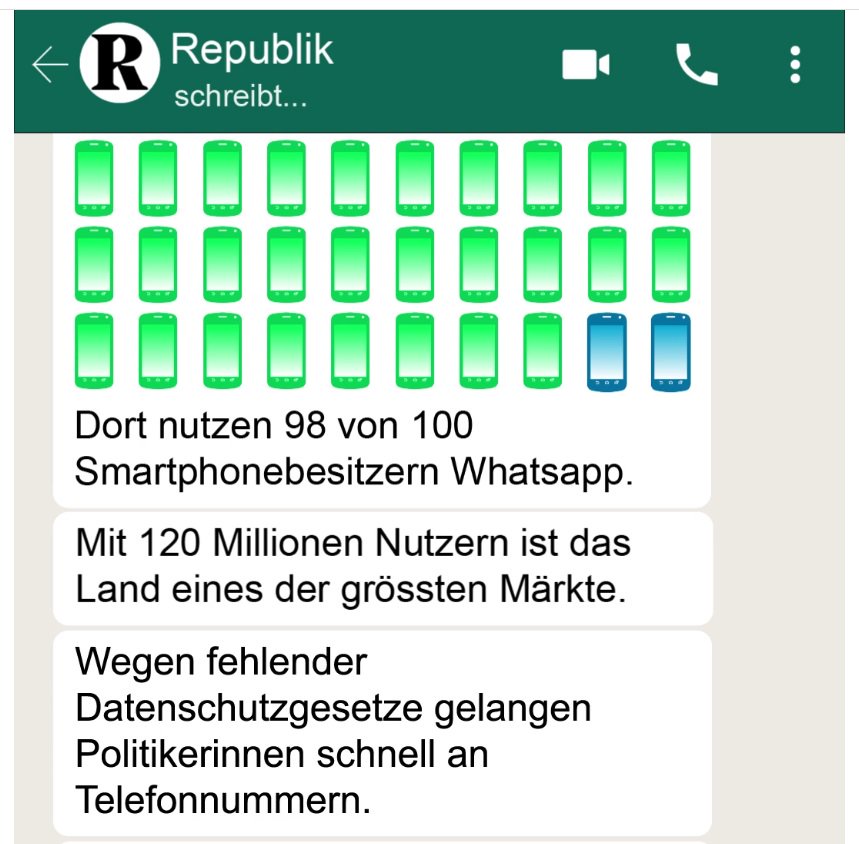

Für die Verbreitung von politischen Ansichten werden immer mehr Messenger-Dienste wie WhatsApp genutzt. Als Beispiel sind hier, die Wahlen in Brasilien (2019) zu nennen. In Brasilien gibt es 120 Millionen WhatsApp-User. Aufgrund fehlender Datenschutzgesetze kommen Politiker in Brasilien einfach und schnell an Telefonnummern. Ihre potentielle Wähler, sind somit ganz praktisch mittels Messenger-Dienste zu erreichen. Auch hier können die Meldungen nicht öffentlich überprüft werden. Ebenso eignen sich Messenger-Dienste zur schnellen Mobilisation von Gruppen. WhatsApp reagierte mittlerweile und schränkte das Weiterleiten von Nachrichten ein.

Bots

Gerade auf Twitter sind Roboter Populationen sehr gross. Adrienne Fichter schätzt diese auf ca. 19% aller Profile. Bots werden bereits auch in digitalen Wahlkämpfen eingesetzt und hatten nachweislich Einfluss auf den letzten amerikanischen Wahlkampf. Ein eindrückliches Beispiel ist das erste TV-Duell zwischen Trump und Clinton. Auf Twitter generierten Bots rund 33% der Pro-Trump-Tweets. Wohingegen Bots nur nur 22% der Clinton-Tweets produzierten. Ebenso erzeugte der Hashtag #Trumpwon eine Schein-Popularität. Medien nahmen die falschen Twitter Trends auf und verbreiteten so die gezielten Irreführungen.

Wieso sind Facebook und Twitter nicht geeignet für einen politischen Diskurs?

- Der Algorithmus belohnt Reaktionen wie Likes und Shares, nicht aber den Inhalt. Die Lautesten profitieren!

- Die Plattformen sind nicht konsensorientiert, sondern wettbewerbsorientiert.

- Homogenität kommt vor Diversität.

- Twitter und Facebook wollen die Verweildauer auf ihren Plattformen maximieren, d.h. sie bevorzugen Opportunismus.

- Die Personalisierung des Internets nimmt weiter zu. Es gibt immer mehr geschlossene Systeme, was zur Folge hat, dass der politische Diskurs immer weniger in der Öffentlichkeit stattfindet.

- Der Umgang mit den Daten ist zu undurchsichtig. Es gibt keine Regulierungen der Digitalkonzerne. Ebenso fehlt es an neutralen Kontrollorganen (Medien, Forschung). Ein institutionalisiertes Code Auditing existiert noch nicht.

Demokratie im 21. Jahrhundert

Adrienne Fichter fordert deshalb eine Regulierung der Plattformen. Die Öffentlichkeit muss Transparenz über die Algorithmen haben und es sollen Kontrollmechanismen installiert werden. Ebenso fordert sie, dass die Plattformen ihre Daten bei Wahlen für die Medien und die Forschung offenlegen. Die Hoheit der Daten auf den Plattformen soll generell bei den Bürgern liegen.

Schlussendlich stehen auch wir, die Social Media Konsumenten, in der Pflicht. Adrienne Fichter empfiehlt, «demokratiefreundliche» Netzwerke wie Democracy OS, pol.is und D-CENT-Tools zu testen. Das sind sogenannte Open Source Netzwerke, deren Quellcode offen ist. Der Vorteil: die User haben die Datenhoheit und können die Funktionsweise nachvollziehen.

Nicht jeder Artikel und jede Neuigkeit entspricht der Wahrheit. Fake News beeinflusst andere Nutzer sowie Medien-Redaktionen. Adrienne Fichter rät deshalb, bei Unsicherheit einer der unzähligen “Bot or Not”-Tools zu nutzen, um zum Beispiel die Echtheit von Twitter Profilen zu testen. Ebenso fordert sie: bleibt kritisch!Wer mehr über das spannende Thema Politik und Soziale Medien erfahren will, dem empfehle ich das Buch “Smartphone Demokratie” von Adrienne Fichter zu lesen.