Je mehr, desto besser? Parameter als Währung für AI

Von Hannah Hohlfeld, Dezember 9, 2022

Von Hannah Hohlfeld, Dezember 9, 2022

Wenn in den Medien von AI-Projekten berichtet wird, erscheint die Anzahl Parameter immer wieder als die Währung, mit der AI-Projekte eingeordnet und gehandelt werden. Schwindelerregende Parameter-Rekordzahlen ergänzen die ohnehin schon oft ins Reisserische tendierende AI-Berichterstattung: So entwickelte sich das weltweit führende Sprachmodell GPT-3 von einem 1,5 Milliarden-Parameter-Netz (GPT-2) hin zu einem künstlichen neuronalen Netzwerk aus 175 Milliarden Parametern. Die 15 Milliarden Parameter des vormals grössten T-NLG-Modells von Microsoft wirken dagegen schon fast bescheiden.

Für fachfremde Leser scheint der Parameter eine angenehm griffige Formel, um AI-Projekte zu bewerten und die technologische Entwicklung mit immer weiter steigenden Parameterzahlen scheint vorgegeben. Doch: Was genau ist ein Parameter im Kontext von AI und warum gilt die Devise: je mehr Parameter, desto besser?

Bei den oben genannten Sprachmodellen geht es um das AI-Teilgebiet Deep Learning. Bei dieser Technologie wird Künstliche Intelligenz auf eine Art und Weise geschaffen, die die Funktionsweise des menschlichen Gehirns zum Vorbild nimmt. In sogenannten künstlichen neuronalen Netzwerken (KNN) werden mathematische Funktionen in einer Topologie verknüpft, die biologischen neuronalen Netzwerken ähnlich ist. Die mathematische Funktion nimmt dabei die Rolle des künstlichen Neurons (oder Netzwerkknoten) ein.

Indem man ein KNN nun Daten verarbeiten lässt, kann es darauf ausgerichtet werden, komplexe Aufgabenstellungen zu lösen, wie Sprach- oder Bilderkennung. Da einem KNN dabei keine genauen Regeln vorgegeben werden, sondern es die Aufgabe mittels der Interaktion seiner Netzwerkknoten gewissermassen selbstständig löst, spricht man von «lernenden Systemen», die mit Daten «trainiert» werden.

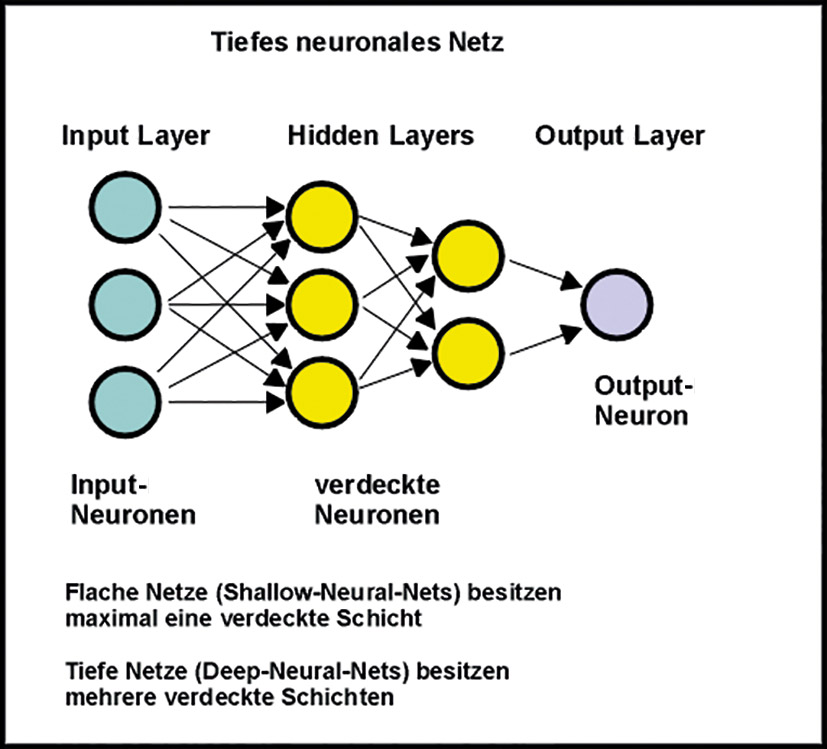

Es gibt verschiedene Arten von KNN-Topologien, die Grundstruktur bleibt jedoch in der Regel gleich: Ein KNN besteht aus einer Input-Schicht (Eingabe der Daten), einer Output-Schicht (Ausgabe der Daten) und verschiedenen Schichten dazwischen, den sogenannten «Hidden Layers» oder Zwischenebenen. Eine Schicht besteht aus einer Reihe von Netzwerkknoten. Die Anzahl der Zwischenebenen bestimmt die «Tiefe» eines KNN und ab einer bestimmten Tiefe spricht man von «Deep Learning»-Netzwerk.

Quelle: entwickler.de

Um die Parameter ausfindig zu machen, muss noch etwas detaillierter in die Netzwerkstruktur eingetaucht werden: Die künstlichen Neuronen im KNN sind so miteinander verknüpft, dass prinzipiell der Output eines Neurons (oder einer mathematischen Formel) als Input an das nächste Neuron (an die nächste mathematische Formel) weitergegeben wird. Eine Weitergabe kann jedoch nur stattfinden, wenn der Output einen gewissen Schwellenwert erreicht hat und dieser hängt von Faktoren ab, die in der mathematischen Funktion des Neurons eingebaut sind: der Gewichtung. Und hierbei handelt es sich um die Parameter. Insbesondere dieses Prinzip des Schwellenwerts für die Weiterverarbeitung von Informationen orientiert sich an der Funktionsweise biologischer neuronaler Netze.

Die Parameter priorisieren und gewichten also die Daten und sind das Element, das im Trainingsprozess durch das Netzwerk selbst beständig angepasst wird, bis das gewünschte Ergebnis erreicht ist.

Die Anzahl Parameter kann beim Aufbau eines KNN durch den Datenwissenschaftler vorgegeben werden. Richtig ist, dass ein KNN mit vielen Parametern sich flexibler und präziser auf die verarbeiteten Daten anpassen kann als ein KNN mit nur wenigen Parametern.

Die fachkundige Bewertung eines KNN erfolgt jedoch mitnichten anhand der Anzahl Parameter, sondern vielmehr anhand einer Reihe von Metriken, die das Ergebnis einer KNN-Rechenleistung bewerten, also beispielweise die Vorhersagegenauigkeit («Accuracy») oder der MAE-Wert («mean average error»), der sich für die Bewertung von statistischen Modellen eignet.

Neben den Parametern gibt es weitere Elemente, auf die Datenwissenschaftler beim Trainieren eines KNN Einfluss nehmen: So hat die Topologie oder Struktur des Netzwerks entscheidenden Einfluss auf seine Leistungsfähigkeit – und sogar die Methode, mit der nach der passenden Topologie gesucht wird – sowie die Wahl der Parameterwerte bei der erstmaligen Eingabe der Daten (Initialisierung).

Also sind Parameter nicht das einzige Charakteristikum, das ein AI-Projekt auszeichnet und für die Bewertung eines Modells werden spezielle Metriken genutzt. Es gilt also nicht: je mehr Parameter, desto besser, sondern: je mehr Parameter, desto rechenintensiver, desto energieintensiver, desto höher die Investition in das Projekt.

Gerade die Energie-Intensität darf kritisch betrachtet werden: So formiert sich in diesem Bereich beispielsweise eine Gegenbewegung von Datenwissenschaftlern, die fordern, KNN nach «Genauigkeit im Verhältnis zum Energieverbrauch» zu bewerten.

Schliesslich handelt es sich bei Parametern im Kontext von AI um ein relativ einfaches und übergreifendes Merkmal, das eine komplexe Thematik zumindest greifbar macht.

Parameter-Rekorde bei AI-Berichterstattung sollte jedoch mit Vorsicht begegnet werden. Die verführerisch einfache Formel kann zu Trugschlüssen verleiten.

Dieser Fachbeitrag wurde im Rahmen eines Leistungsnachweises für das CAS AI Management verfasst und wurde redaktionell aufgearbeitet.

Unser Newsletter liefert dir brandaktuelle News, Insights aus unseren Studiengängen, inspirierende Tech- & Business-Events und spannende Job- und Projektausschreibungen, die die digitale Welt bewegen.