Ethik – menschliche Überlegenheit

Oktober 22, 2019

Schon bald ist Halbzeit im CAS Disruptive Technologies. Vieles haben wir schon angeschaut – Technologien wie Artificial Inteligence (AI), oder Chatbots, Anwendungsbeispiele und rechtliche Grundlagen oder mögliche Plattformen und Eco-Systeme. Höchste Zeit also, sich auch mal das Thema Digitale Ethik etwas vertiefter anzuschauen.

Nebst all dem ‘wow’ und den neuen spannenden Möglichkeiten, die sich mit Künstlicher Intelligenz (KI) und Big Data auftun, wird es immer relevanter sicherzustellen, dass solche digitale Technologien so eingesetzt werden, dass sie möglichst niemandem Schaden zufügen, diskriminierend agieren, die Privatsphäre geschützt halten und möglichst transparent und nachvollziehbar sind. Mit diesen Ansprüchen sind wir schon voll im Thema angekommen.

Gelingt es uns digitale Helferlein und Maschinen so zu bauen, dass diese Aspekte eingehalten werden? Dies sollte doch möglich sein. Wir sprechen hier von ‘menschlicher Überlegenheit’ den Maschinen gegenüber. Eine Überlegenheit die wir unbedingt waren sollten, denn nicht immer ist die logiste auch die beste Entscheidung. Es kommt ganz auf die Situation darauf an, nicht? Lasst uns eintauchen und verstehen, warum Digitale Ethik so relevant und der Erfolgsfaktor für Künstliche Intelligenz ist.

Im angelsächsischen Bereich wird KI schon viel ausgeprägter eingesetzt und genutzt als in der Schweiz. Ebenfalls in der EU und in UK sind KI und Ethik bereits weiter fortgeschritten und intensiver behandelt als hierzulande. Obwohl, die Debatten laufen langsam heiss und die Auseinandersetzung mit dem Thema bekommt Schwung.

Erst einmal ein paar Grundlagen.

Gemäss Wikipedia kommt der Begriff Ethik aus dem Griechischen wo er das sittliche Verständnis, den Charakter, oder die Sinnesart umschreibt. Im Zentrum der Ethik steht das spezifisch moralische Handeln, insbesondere hinsichtlich seiner Begründbarkeit und Reflexion.

Die Ethik wird auch als philosophische Reflexion von begründbaren moralischen Geltungsansprüchen beschrieben. Die zentrale Frage ist, wie wir leben sollen und an welchen Zwecken und Werten unser Handeln orientiert ist? Mit Geltungsanspruch ist all das gemeint, das von menschlichem Handeln beeinflusst werden kann und alles was in unserer Verantwortung liegt. Das beinhaltet aber auch alles, das anders sein könnte, wenn wir uns anders verhalten würden.

In der Vergangenheit war Ethik nur für einen erlesenen Bereich von Personen bestimmt. Heute gilt die Ethik für alle Menschen, da alle gleichwertig sind, auch wenn dies in der Realität leider noch lange nicht überall umgesetzt ist. Moralische Pflichten bestehen auch gegenüber der Umwelt, z. B. Bäumen oder Tieren.

Neu spricht man auch von technischer Moral, man denke hierzu beispielsweise an ein Kernkraftwerk. Was für Verantwortungen bestehen da? Grundsätzlich hat sich Moral und Ethik über die Zeit räumlich und zeitlich ausgedehnt. Der nächste Schritt wird wohl die Auseinandersetzung mit der Weiterentwicklung und Zusammenschmelzung von Menschen und Technik sein, das sogenannte Bio Hacking.

Lassen wir uns mal auf die technische Moral, oder besser gesagt auf die technische Ethik ein. Was bedeutet dies für die Künstliche Intelligenz? An welchen moralischen Werten sollen wir uns bei der Entwicklung von KI orientieren? Was soll der Zweck der technischen Lösung sein und welche ethischen Implikationen hat die KI? Welche Werte sollen bei automatischen Entscheidungen priorisiert werden; wie stehts um Fairness, Gleichheit, Transparenz, Genauigkeit, Privatsphäre oder Effizienz?

Im Zusammenhang mit Ethik und KI gilt es ein paar Fettnäpfchen zu berücksichtigen, bzw. zu umgehen:

«Um Ethik praktisch und handlungsorientierend zu gestalten, müssen wir unsere moralischen Werte in eine benutzerfreundliche Compliance-Checkliste übersetzen. Wenn wir uns für eine bestimmte technologische Massnahme entschieden haben, konsultieren wir einfach die Checkliste, um sicherzustellen, dass wir ethisch gesehen ‘compliant’ sind»

«Wir sind uns uneinig, was moralisch wertvoll ist. Es gibt keinen universellen Massstab, um unsere moralischen Entscheidungen zu bewerten. Nichts ist objektiv gesehen moralisch korrekt: Ob etwas moralisch ist oder nicht, kann nur relativ zu den jeweiligen persönlichen Überzeugungen bestimmt werden».

«Die Ethik ist im Wesentlichen das Gleiche wie die Gesetzgebung. Wenn wir keine passenden gesetzlichen Kategorien für die Steuerung von KI haben, ist Ethik ein guter Ersatz für das Gesetz. Und wenn wir genügend griffige Gesetze haben, müssen wir nicht über Ethik nachdenken.»

Nachfolgend wird auf die 4 Ankerpunkte näher eingegangen.

Künstliche Intelligenz, bzw. Machine Learning beruht auf der Prämisse von sammeln, verarbeiten und verbinden von grossen Datenmengen, ein Grossteil davon persönliche Daten.

Die Herausforderung von KI, welche auf dem Prinzip von Big Data beruht, ist folgende: Je mehr Daten gesammelt wurden, desto glaubwürdiger bzw. genauer ist die KI. Aus datenrechtlichen Gründen ist dies jedoch genau das Problem. Es kann häufig bereits heute nicht mehr im Detail erklärt werden wie die Maschine zum Resultat gefunden hat. Zudem, je mehr Datenquellen involviert sind desto schwieriger ist die Rückverfolgung und Schlussfolgerung. Der Zweck der KI ist es ohne menschliches Zutun oder Interaktion eine Aufgabe zu lösen. Wenn nun menschliche Intervention hinzukommt, um Datenschutzvorgaben zu erfüllen, wird die Komplexität von KI-angetriebener Entscheidungsfindung eingeschränkt.

Organisationen, die mit KI arbeiten, müssten somit nicht nur ihre Algorithmen enthüllen, sondern auch alle Daten, die durch ML verwendet und die Art und Weise wie die Daten gesammelt wurden. Das ist in der Praxis nur schwer umsetzbar und ethisch problematisch. Wird verlangt, dass menschliche Supervision das System überwacht, wird die Branche noch teurer. Ausserdem können hohe finanzielle Risiken entstehen, wenn eine Organisation KI nutzt und nicht GDPR konform ist. Gerade gemäss GDPR müssen Organisationen Kundendaten auf Anfrage löschen. Diese Regel widerspricht der Ideologie des ‘Konsumierens, Aufbewahrens, Memorisierens, und Verknüpfens von Big Data, um effiziente Lösungen anzubieten’, sie widerspricht also der Basis, auf welcher KI beruht.

Grosse Datenmengen erlauben der KI also smarter und menschenähnlicher zu werden und Entscheidungen präziser vorauszusagen. GDPR wäre somit eine direkte Konsequenz für Innovation, weil die Trainingsdaten, für KI minimiert werden müssten.

Anhand folgenden Beispiels soll der Unterschied zwischen normalem Engineering und KI erklärt werden: Stürzt ein Haus ein, könnten die Behörden den Fehler untersuchen und die Ingenieure verantwortlich machen. Die Lektion wird gelernt und in Zukunft wird der Fehler vermieden. Beim Kodieren hingegen ist dies etwas anders: Es liegt in der Natur von KI, dass die Erschaffer oft nicht voraussagen können, was ihre ‘Produkte’ tun werden. Wir wissen, wie wir Maschinen dazu bringen können, zu lernen. Aber Entwickler verstehen noch nicht vollständig, welches Wissen sich intelligente Maschinen aneignen. Wenn dies schon möglich wäre, bräuchte es keine Systeme, die lernen wie sie am besten lernen. Es wäre bekannt was diese Systeme tun und wäre bereits im Code berücksichtigt. Systeme können ein Gesicht oder eine Stimme erkennen, sie können so trainiert werden, dass sie Computerspiele gewinnen etc. jedoch kann noch keine genaue Aussage gemacht werden, wie sie dies schaffen. Darin liegen die Genialität und Verrücktheit dieser Technologie.

Nochmals ein Beispiel aus California: Per Gesetz ist es neu zwingend, dass die künstliche Identität eines Bots offengelegt wird, um bei Wahlen Einflussnahme auf die Wähler zu verhindern.

Global gesehen gibt es wie drei Ausprägungen von Künstlicher Intelligenz:

Weitere Ausprägungen bilden sich gerade in Russland und Indien, die wirtschaftlich aufholen aber bezüglich Menschenrechte noch nicht mit Europa vergleichbar sind.

Nachfolgend zoomen wir auf den Europäischen Raum und schauen mal was für ethische Aspekte auf den 4 Ankerebenen gelten.

In der EU bestehen bereits erste Ethik Leitlinien für eine vertrauenswürdige KI. Die menschliche Handlungsfähigkeit muss daher zu jeder Zeit gewährleistet sein. Es darf somit nicht sein, dass man einem autonomen Auto komplett ausgeliefert ist.

In der Europäischen Union bestehen die folgenden 7 Anforderungen an die KI:

Corporate Digital Responsibility (CDR)

Handlungsfelder der CDR

Globale Unternehmen wie Google und Microsoft haben unternehmensweite KI Prinzipien im Einsatz.

Google KI Prinzipien:

Zwei Punkte die wir rauspicken:

Microsoft – Nachfolgend die Regeln für ‘Conversational AI’ (bots) und Guidelines für Developers:

Quelle: Microsoft.com

Diversity-Massnahmen

Trainings

Grundsatz: Bereits beim Kodieren wird schon auf Diversity und maximaler Reduktion von einem Bias geachtet, indem beispielsweise homogene Entwicklergruppen vermieden werden.

Mathematische Formulierung der folgenden Ideologie: es wird verglichen, was man aus einer Analyse ableiten könnte, wenn die Daten einer bestimmten Person im Datensatz enthalten gegenüber dem, was man lernen könnte, wenn sie nicht enthalten sind.

Differential Privacy verlangt, dass das Hinzufügen oder das Entfernen des Datensatzes eines Individuums die Wahrscheinlichkeit eines Ergebnisses nicht wesentlich verändert. Es schützt vor willkürlichen Schäden und garantiert, egal wie die Daten strukturiert und wovor man in diesem Zusammenhang allenfalls Befürchtungen hat, dass es nicht wahrscheinlicher wird, wenn der Datensatz eines bestimmten Individuums in der Studie enthalten ist oder nicht.

Zusätzlich kann die Differential Privacy als Versprechen gesehen werden, dass kein Aussenstehender viel über einem erfährt. Das gilt für jedes Individuum im Datensatz und für jeden Beobachter, unabhängig von ihren ursprünglichen Anschauungen. Wird das Resultat einer Differential Privacy angeschaut, ist die Betrachtung fast die gleiche wie wenn man das Resultat der gleichen Berechnung ohne die Daten des Individuums angeschaut hätte.

Die Definition von Fairness: Dies kann an folgendem Beispiel als statistische Parität gesehen werden: Der Anteil von weisshäutigen Personen, die einen Kredit bekommen, soll gleich dem Anteil dunkelhäutiger Menschen sein. Also der gleiche Prozentsatz an Kreditvergabe für beide Ethnizitäten.

Dies ist keine ideale Definition von Fairness, da die Eigenschaften der Personen ignoriert wird. Es kann eine zufällig ausgewählte Anzahl Personen ausgewählt und ihnen Kredit vergeben werden. Der entsprechende Algorithmus ist nicht geeignet für eine Kreditvergabe.

Eine statistische Parität legt das Ziel von Voraussagen eines Modells nicht fest, sondern schränkt diese Voraussagen ein. Die Spannung zwischen Fairness und Genauigkeit ist eher hoch.

Eine andere Definition von Fairness wäre Verdienst und verlangt, dass die gemachten Fehler gleichmässig verteilt werden, sprich: “all else being equal.” Die Ethnizität hat keinen Einfluss auf die Wahrscheinlichkeit, dass unser Algorithmus jemandem schaden kann.

Am besten erklärt anhand einem Pendler-Game: “Maximum social welfare solution.” Aufgabe: minimiere die Fahrzeit über die ganze Bevölkerung hinweg, anstelle der Minimierung der Fahrzeit eines jeden Users. Das heisst, die Wissenschaft kann nur bis zu einem gewissen Punkt herangezogen werden und menschliches Urteilsvermögen bzw. Normen werden immer eine zentrale Rolle spielen bei der Wahl, wohin sich eine Gesellschaft entwickeln will und welche Ideen (z.B. Fairness) gefördert werden sollen.

Ein gutes Design beim Algorithmus kann eine Auswahl an Lösungen anbieten. Welche davon schlussendlich genutzt werden soll, muss dann durch die Menschen selbst gewählt werden.

Im Zusammenhang mit Ethik sind noch weitere Aspekte wie Blind Spots, Bias, Diskriminierung und Fairness höchstrelevant und lohnenswert untersucht zu werden:

Was sind Ethische Blind Spots? Schauen wir uns diese mal etwas genauer an. Zum Beispiel anhand der Ethik im Machine Learning Life-Cycle. Vielfach dreht sich die Forschung im ML Bereich nur gerade um diejenigen Tätigkeiten unterhalb der gestrichelten Linie. Also hauptsächlich den Trainingsprozess.

Die Ethik muss aber über den ganzen Prozess hinweg bei allen Aspekten miteinbezogen werden, wie untere Abbildung zeigt. Dabei sollen folgende Fragen helfen:

Was ist ein Bias? Eine systematische Verzerrung in Daten, die ihren Nutzen für eine Aufgabe kompromittieren.

Wie und wo entsteht Bias? Grundsätzlich kann in allen Projektphasen und in allen Komponenten ein Bias entstehen: Während dem Design, in den Datensätzen, im Model oder bei der Applikation selbst.

Achtung, ein Bias muss nicht zwingend unethisch sein. Der Daten Bias muss immer im Verhältnis zur Aufgabe betrachtet werden. In der Medizin muss manchmal sogar bewusst ein Bias miteinbezogen werden, wenn es darum geht eine Zielgruppe einzuschränken: z.B. Frau, 45 Jahre, Raucherin, Brustkrebs, etc.

Die Ursache zu dem reduzierten Risiko wurde schliesslich in der intensiveren Betreuung der Asthma- Erkrankten durch Fachpersonal gefunden, welche etwelche Anzeichen zu Lungenentzündung mittels regelmässiger Untersuchung früher erkannt haben. Ein Bias, da Asthma erkrankte Personen viel früher im jeweiligen Stadium behandelt wurden.

Was ist der Unterschied zwischen Bias und Diskriminierung? Bias ist ein technisches Konzept, das sich z.B. auf Selektion, Sampling oder Reporting bezieht. Diskriminierung betrifft Eigenschaften, die als Basis für ungerechtfertigte und systematische Ungleichbehandlung in der Vergangenheit dienten. Sie ist abhängig vom Anwendungsfeld. Spitzfindig gefragt: Ist die Diskriminierung nicht der ‚Clou‘ von Machine Learning?

Grundsätzliche sind Algorithmen ‘Black Boxes’ die durch Geschäftsgeheimnisse, rechtliche Grundlagen oder vorsätzliche Verdunkelung geschützt sind. Die Diskriminierung wird somit unsichtbar und eine Eliminierung oder Reduzierung verunmöglicht.

Man stelle sich nur vor Google müsste deren Such- Algorithmus offenlegen, oder Coca-Cola ihr Geheimrezept zum Drink.

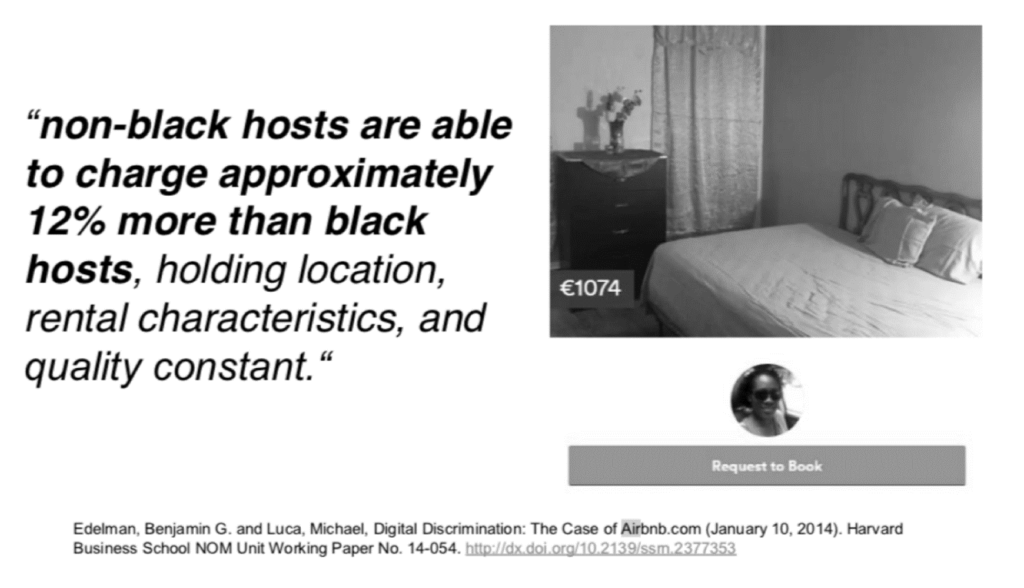

Folgende Studie zeigt eine Diskriminierung, begründet auf algorithmischem Bias: Online-Marktplätze enthalten oft Informationen nicht nur über Produkte, sondern auch über die Menschen, die die Produkte verkaufen. Um Vertrauen zu schaffen, ermutigen viele Plattformen Verkäufer, persönliche Profile zur Verfügung zu stellen und sogar Bilder von sich selbst zu posten. Diese Merkmale können jedoch auch die Diskriminierung aufgrund der Rasse, des Geschlechts, des Alters oder anderer Merkmale der Verkäufer erleichtern. In einer Studie zur Rassendiskriminierung wurde aufgezeigt, dass bei AirBnB nicht-schwarze Gastgeber etwa 12% mehr als schwarze Gastgeber für die entsprechende Miete verlangen können und auch erhalten . Es wird somit das Risiko von Diskriminierung auf Online-Marktplätzen aufgezeigt und deutet auf eine wichtige unbeabsichtigte Folge eines scheinbar routinemäßigen Mechanismus zur Vertrauensbildung hin.

Was wird unter Fairness verstanden? Welche der drei nachfolgenden Abbildungen ist fair?

Die obige Abbildung zeigt 3 verschiedene Konzepte von Fairness um das Bedürfnis, ein Fussballspiel zu verfolgen, gestillt werden kann.

Es stellt sich die Frage welche Art von Fairness ist gewollt und/ oder soll unter Umständen in ein bestehendes System eingegriffen werden? Nachfolgend eine Übersicht über die Bedeutung von Fairness. Und wieder gilt, gleich wie bei der Ethik, jede Kultur hat eine andere Sichtweise und Verständnis zu Fairness.

Abschliessend kann gesagt werden, dass es kein ‘One size fits for all’- Lösung gibt. Weder für Fairness noch für die Ethik. Gefragt ist, mehr denn je, gesunder Menschenverstand, Empathie und emotionale Intelligenz und eine auf die jeweilige Situation gerechte Entscheidung. Eigenschaften, die wir Maschinen gegenüber voraushaben. Eine quasi menschliche Überlegenheit.

Fazit: Das Thema Ethik in der digitalen Welt rückt mehr und mehr ins Zentrum des Geschehens. Wir stehen an der Weggabelung und es gilt die richtige Abzweigung zu erwischen, wenn wir unsere Zukunft nicht verbocken wollen. Ethik geht uns alle an, jetzt und in Zukunft.

Es war ein kurzweiliger und spannender Vormittag mit vielen Fragen und Aha- Momenten, die zum Nachdenken anregten. Vielen Dank Doro für deinen Unterricht, die vielen Insights und Anregungen – das war äusserst aufschlussreich.

Unser Newsletter liefert dir brandaktuelle News, Insights aus unseren Studiengängen, inspirierende Tech- & Business-Events und spannende Job- und Projektausschreibungen, die die digitale Welt bewegen.