Digitale Ethik – Was Kunden von Unternehmen erwarten

Juli 12, 2019

Dieser Vormittag verspricht sehr interessant zu werden, so wie jeder Tag des CAS Digital Masterclass. Das Besondere am Thema Digitale Ethik ist aber, dass es von den Studierenden selbst als Thema gewählt wurde. Wir werden von Cornelia Diethelm begrüsst, sie ist die Gründerin des Centre for Digital Responsibility (CDR) – dem Think Tank für Digitale Ethik. Zudem leitet Sie auch den HWZ Studiengang CAS Digital Ethics.

“Privacy & Ethics” gehört gemäss Gartner zu den “Top 10 Strategic Technology Trends for 2019”. Der Begriff Ethik als philosophische Teildisziplin, mit Fokus auf moralisches Handeln, ist wohl jedem bekannt. Doch wie ist Digitale Ethik zu verstehen? Tim Cook, CEO von Apple sagte:

“We will never achieve technology’s true potential without the full faith and confidence of the people who use it.”

Wir brauchen also das Vertrauen der Menschen, dass auch in digitalen Belangen moralisch gehandelt wird. Cornelia Diethelm schafft es, uns in kürzester Zeit mit einigen negativen Fallbeispielen aufzuzeigen, was man unter Digitaler Ethik verstehen kann und dass es ziemlich schief gehen kann, wenn man sich darüber keine Gedanken macht.

Wenn du weiterliest, sei dir bewusst, dass es nicht darum geht Digitalisierung in ein schlechtes Licht zu rücken, sondern darum aufzuzeigen, dass wir uns dringend mit grundsätzlichen ethischen Fragestellungen beschäftigen müssen. Dabei soll nicht vergessen werden, dass man dies aus unterschiedlichen Perspektiven oder Rollen tun kann und soll – als Privatperson, Eltern, Unternehmen, Politiker und Politikerin, als Bestandteil unserer Gesellschaft, etc.

Swisscom hat vor kurzer Zeit Sensoren an Schweizer Bahnhöfen installiert. Es handelt sich um kleine schwarze Kästchen, die oberhalb von Plakatwänden installiert wurden. Dies war die Vorbereitung für die neue Werbeplattform “Beem”, mit der sich interaktive Werbung auf die Smartphones von Nutzern in der Nähe schalten lässt. Das Problem? Kommunikation! Man hat versäumt die Schweizer Bevölkerung vor der Installation aufzuklären, um was es bei den Signal aussendenden schwarzen Kästchen geht. Auch scheint unklar, welchen Einfluss dies auf die individuelle Privatsphäre von Nutzern hat. Nicht verwunderlich, dass Swisscom nach den vielen Unmuts-Bekundigungen die Werbekampagne verschoben hat und nun zuerst darüber aufklären möchte – was “Beem macht” – und was eben auch nicht. Können Sie das Vertrauen zurückgewinnen?

Target, der zweitgrösste Einzelhändler der USA versendete Coupons z.B. für Babykleider und Babybetten, wenn die Nutzerdaten anhand von 25 Kriterien darauf hinwiesen, dass die Nutzerin schwanger ist. 2012 In Minneapolis führte dies zu einem sehr aufgebrachten Vater, dessen minderjährige Tochter diese Gutscheine erhalten hat. Er war empört darüber, dass die minderjährige Tochter durch solche Werbung dazu verleitet werden könne, Kinder zu kriegen. Das Management entschuldigte sich in aller Form, erhielt jedoch kurz darauf eine Nachricht des Vaters, dass ein Gespräch mit der Tochter ergeben habe, dass sie tatsächlich schwanger sei. Nichtsdestotrotz -Ein Eingriff in die Privatsphäre dieser Familie, v.a. der schwangeren Tochter.

Der Einsatz von Stimmerkennung bietet viele Annehmlichkeiten – unbestritten. Jedoch ist auch hier wieder der ethische Umgang mit dieser Technologie gefragt. Swisscom sowie Postfinance stellten vor kurzem erstmals für erhaltene Anrufe ihrer Kunden die Stimmerkennung zu Verfügung. Damit werden die lästigen Fragen zur Beginn des Telefonats, zwecks Bestätigung deiner Identifikation, hinfällig. Toll oder? Bevor die eigene Stimme aufgenommen wird, erhält man entweder die Chance aufzulegen oder man wird aufgefordert mit einer Taste zu bestätigen, dass man damit einverstanden ist – auch eine nachträgliche Reklamation im Kundencenter ist möglich. Die meisten Kunden sind einverstanden, doch womit? Cornelia Diethelm sieht ein Problem darin, dass die Kunden nicht wissen, was ein Stimmabdruck überhaut ist und für was er verwendet wird. Man kann hier also nicht von einem Einverständnis sprechen. Am Telefon kann man ja auch nicht nachfragen, für was genau die Stimme verwendet wird oder sich über die Bestimmungen informieren.

Übrigens auch hier krebste Swisscom zurück. Weil es zu Aufruhr geführt hat, dass bei der Einführung der Stimmerkennung am Telefon lediglich darüber informiert wurde anstatt das Einverständnis aktiv abzuholen. Seit April 2019 hat Swisscom sämtliche Stimmdaten der Kunden gelöscht und verzichtet auf diese Technologie. Postfinance, welche dieselbe Technologie “NICE” (aus Israel) verwendet, fragte Kunden zuerst nach ihrem Einverständnis und erhielt sehr viele positive Reaktionen damit. Im Anschluss wechselte die Postfinance das Verfahren. Statt nach dem Einverständnis zu fragen, informieren sie nur noch darüber.

Ein Stimmabdruck dient nicht nur der Identifikation, er verrät noch viel mehr über einen Menschen. Die Stimme enthält um die 1000 Merkmale, durch die sich auf Charaktereigenschaften schliessen lässt, z.B. ob du extrovertiert, genau oder kreativ bist. Das Unternehmen Retorio aus München oder das Schweizer Unternehmen Softfactors bieten mit Stimm- und Gesichtsabdruck einige der möglichen Dienstleistungen an:

Aber welche Unternehmen arbeiten mit Stimmanalysen? Firmen geben nicht zu, dass sie diese Software verwenden, wahrscheinlich weil sie Angst vor schlechter Publicity haben. Im SRF Beitrag wird davon gesprochen, dass die Technologie bereits von Schweizer Unternehmen im Detailhandel, der Versicherungsbranche sowie Callcentern eingesetzt wird.

In einer angeregten Diskussion tauschen wir uns in der Klasse dazu aus, was wir von der Stimmanalyse bei der Bewerberselektion halten. Hier einige Punkte aus der Diskussion

Die Problematik bei ethischen Themen ist, dass es kein schwarz und weiss gibt. Vielfach sind die Grenzen zwischen richtig und falsch unklar. Cornelia Diethelm gibt uns jedoch einige ethische Orientierungspunkte als Hilfestellung, die bei der Betrachtung eines ethischen Dilemmas helfen können:

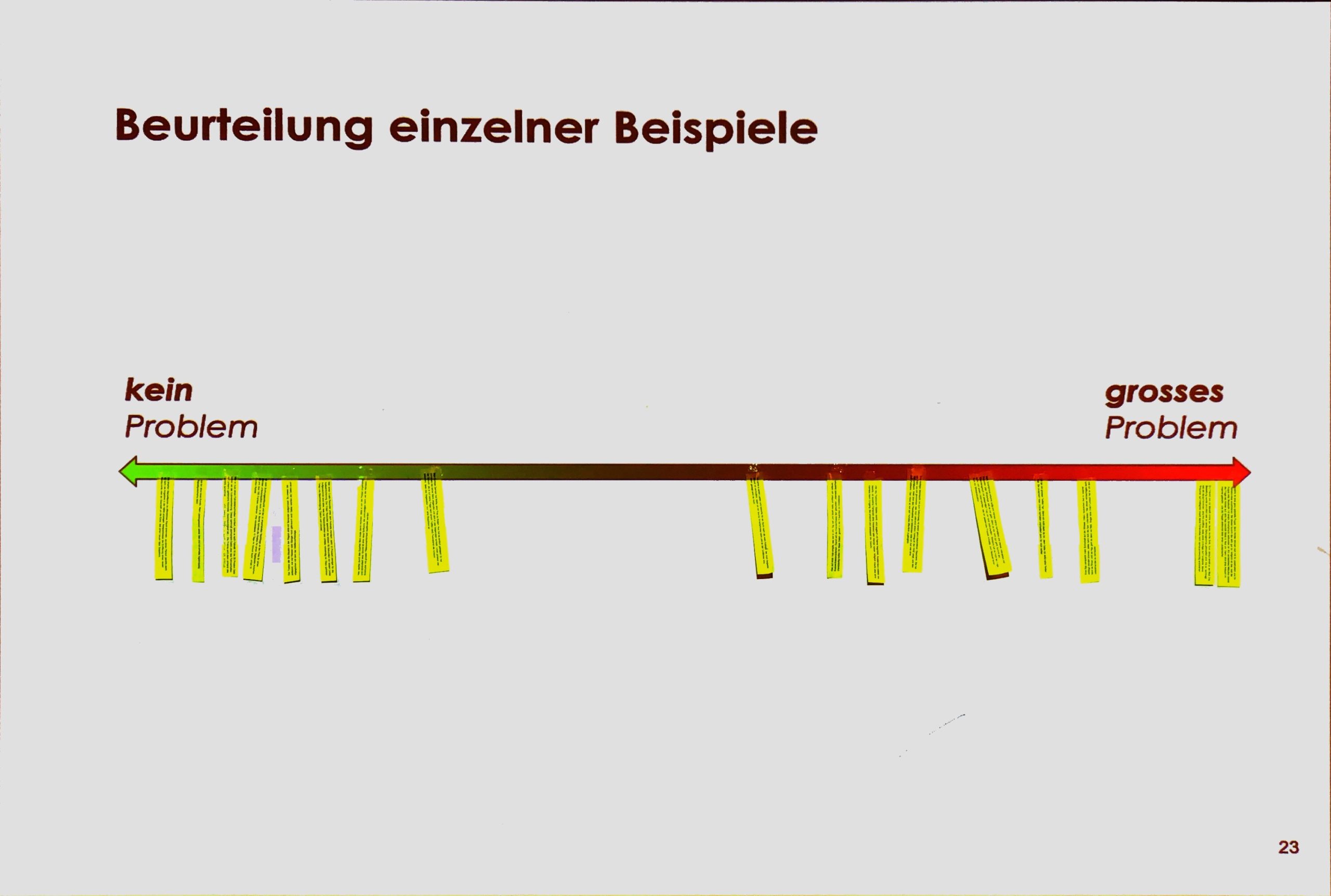

Erneut bekommen wir aufgezeigt, dass es nicht ganz so einfach ist, einzuordnen ob etwas unproblematisch ist oder nicht, wenn es um die digitale Ethik geht. Cornelia Diethelm teilt jeder Studentin und jedem Studenten einen Fall zu. Wir müssen jeweils entscheiden ob der Fall unproblematisch, also auf der “grünen” Seite ist, oder auf der roten, problematischen Seite und uns dabei mit Gegenargumenten von der Klasse auseinandersetzen.

Zum Glück gibt’s hier auch viele positive grüne Beispiele z.B. Folgende:

Die zwei Beispiele, die wir nun in der Klasse diskutieren, machen klar, dass trotzdem immer noch vieles unklar ist, wenn es um richtig und falsch geht.

Zuerst sprechen wir über Akihiko Kondo. Er ist einer von 4000 japanischen Männern, welche alle das virtuelle Hologram “Hatsune Miku” geheiratet haben und sehr glücklich damit sind. Soll es erlaubt sein ein Objekt heiraten zu können? Was ist die Idee und Definition von Heirat? Gibt es kulturelle Unterschiede in dieser Frage (in Japan hat alles eine Seele egal ob Mensch, Tier, Pflanze oder Gegenstand)? Schadet das jemandem? Schadet es uns als Gesellschaft wenn plötzlich eine Mehrheit der Menschheit mit Objekten verheiratet sind? Ich mache in der Klasse einen Kommentar dazu und merke dass ich von «it» statt von «her» spreche.

Nach einigen erstaunten Lachern zum letzten Beispiel, wird es etwas ernster mit dem Sexroboter “Harmony”. Dieser verfügt über “Widerstandseinstellungen”, mit welchen sich eine Vergewaltigung des Roboters imitieren lässt. Einige Sexroboter sehen auch aus wie minderjährige Kinder. Heftiges Thema. Warum sollte es erlaubt sein einen Roboter zu vergewaltigen, wenn es im echten Leben mit Menschen auch verboten ist? Verhindert dies vielleicht sogar Vergewaltigungsfälle im echten Leben? Führt dies zu einem Anstieg von Vergewaltigungen weil Menschen keine Grenze mehr ziehen zwischen echten Menschen und Sexrobotern?

Wie soll eine Gesetzgebung dazu aussehen? Eine Statement dazu wäre:

“wenn etwas in der realen Welt verboten ist, dann soll es auch in der digitalen Welt verboten sein.”

Die UNO hat einen Bericht dazu verfasst an dem viele mitgearbeitet haben, u.a. auch Doris Leuthard oder Jack MA, Gründer der Alibaba Group. Der Report geht u.a. in die Richtung, dass es eigentlich nicht unbedingt neue Gesetze braucht, aber dass die bestehenden Gesetze in der digitalen Welt auch zur Anwendung kommen sollen. Sind dann auch Shootergames verboten? Oder ein Film in dem ein Mord zu sehen ist? Wo ist die Grenze? Liegt sie dort wo unser menschliches Hirn noch unterscheiden kann was real ist und was nicht?

Es kommen immer mehr Guidelines, nicht nur in Europa, weil Menschen die Entwicklungen und Produkte nur verwenden, wenn sie ihnen trauen (z.B. Ethics Guideline der EU vom 8. april 2019). Auch Gütesiegel für Unternehmen werden entwickelt und vermehrt Personen in Unternehmen angestellt deren Aufgabe es ist, sich um die digitale Ethik zu kümmern. Es wird Zeit, sich mehr mit digitaler Ethik auseinanderzusetzen!

“Consumers have an growing awareness of the value of their personal

information, and they are increasingly concerned with how it’s being

used by public and private entities. Enterprises that don’t pay

attention are at risk of consumer backlash” (Gartner).

Was Unternehmen tun können? Lese mehr dazu im HWZ Whitepaper zu Digitaler Ethik.

Unser Newsletter liefert dir brandaktuelle News, Insights aus unseren Studiengängen, inspirierende Tech- & Business-Events und spannende Job- und Projektausschreibungen, die die digitale Welt bewegen.