Datenjournalismus – Storytelling mit Hilfe von Daten

Oktober 5, 2018

Aus dem Unterricht des CAS Disruptive Technologies mit Barnaby Skinner berichtet Steven Roth.

Der Kurs Datenjournalismus wurde in 4 Teile geordnet:

Barnaby Skinner hat uns durch seine persönliche Erfahrungen und Werdegang eine Einführung in das Thema Datenjournalismus gegen. Er leitet seit einem Jahr bei der Tamedia die Gruppe Datenjournalismus.

Als Reporter für Technologie war er einige Male in Silikon Valley und mehr und mehr sah er das Potential, neue Technologien zu verwenden, um an Datensätze zu kommen. Bislang waren diese Datensätze nur mit sehr grossem Aufwand – wenn überhaupt – zu beschaffen. In 2012 nahm er an einem Hackday teil, wo es unter anderem um Mobilitätsdaten ging. Eingeladen waren Entwickler, Designer sogar Politiker. Ebenfalls vor Ort waren Leute von der SBB, die bereits über einige Datensätze betreffend Mobilität verfügten.

Was konnte man mit diesen Daten nun anfange ? Zusammen im Team kam die Idee, Mobilitätsdaten mit Immobiliendaten zu verbinden, um zu sehen, wo man gut erschlossen, billig wohnen kann.

Diese Story zeigte unter anderem auch, dass data driven story telling in Verbindung auf digitalen Channels einfacher personalisierbar sind, in diesem Fall konnte man seine eigene Adresse angeben, um zu sehen wo der eigene Wohnort zum Thema steht.

Barnaby erklärte weiter, dass es leider oft schwer ist, an gute Daten zu kommen, zumindest an günstige. Mehr und mehr sind sich die Firmen bewusst, dass ihre Daten Assets sind und stellen diese nicht einfach gratis zur Verfügung. Es gibt aber viel Daten aus der öffentlichen Hand, leider sind diese aber meist nicht wirklich interessant. Mehr und mehr wird es daher für einen Datenjournalist nötig, gewisse Coding Skills zu besitzen, um selber Daten aus dem Web zu extrahieren. Man kann mit Hilfe des Scrapings Quelltext einer Website auslesen und extrahieren und damit rohe Datensätze generieren. Nach dem Auslesen werden diese Datensätze mit Hilfe eines Datenverarbeitungsprogramm bereinigt.

Ein gutes Tool für das Scraping ist Outwit Hub, hier kann bereits ohne viel Programmierung viel erreicht werden und das Tool ist kostenlos.

Für die Datenverarbeitung wurde uns Open Refine ans Herz gelegt, auch ein Open Source, ebenfalls free und open source.

Nach diesem eher technischen Exkurs wurden uns zwei weitere Stories näher gebracht. Die eine handelte von airbnb in der Schweiz. Es wurden über 15’000 Angebote gescraped, um zu sehen, wie viele Einzelpersonen hinter diesen airbnb Angebote in der Schweiz stehen. Die Erkenntnis war, dass es Personen in der Schweiz gibt, die mit bis zu 70 Angeboten handeln aber technisch gesehen keine Hoteliers sind und z.b. auch so Kurtaxen und Versicherungstechnische Vorlagen umgehen können.

Eine weitere Story handelte davon, dass man einen “Claim” im Detailhandel überprüfen wollte, wonach der Detailhandel in der Schweiz einen sehr grossen Anteil an Frauen in Führungspositionen haben soll. Mit Hilfe von Scraping wurden auf den verschiedenen Webseiten der Detailhändler wie z.b. Coop oder Migros nach Filialleitern gesucht und dann mit Hilfe der Vornamen versucht die Geschlechter zu identifizieren.

Als nächstes machten wir dann eine Übung:

Erarbeitung einer Fragestellung, die einer Daten-Analyse zu prüfen ist (10 min)

Eine guter Vorschlag war zum Beispiel “Gibt es tatsächlich mehr oder weniger Fahrzeug-Unfälle auf Strecken, wo Radarkontrollen durchgeführt werden ?” Daten wären womöglich via dem Bundesamt für Statistik und den kantonalen Radar-Ausschreibungen zu beschaffen.

Oft reichen dem Datenjournalist die zu Verfügung stehenden Tools bzw. deren Funktionalitäten nicht mehr aus, um die mehr komplexeren Datenquellen auszulesen. Meist geht es dort dann nicht mehr ohne “custom coding”. Programmierkenntnisse für Datenjournalisten sind daher ein “Must”, wenn er an die wertvollen oftmals versteckten Daten kommen möchte. Eine gute Adresse, um als Journalist das Coding zu erlernen, ist das “Lede Program”

Datenjournalismus ist seit längerer Zeit ein Thema bzw. ein Arbeitsfeld. Er entstand aus dem investigativen Journalismus, ein anderes Wort für Datenjournalismus ist computer assisted reporting. Eine sehr bekannte Konferenz in diesem Bereich ist die NICAR, wo Barnaby auch schon teilnahm.

Barnaby erklärte uns weiter, dass die Open Source Bewegung und die daraus entstandene Community eine grosse Hilfe darstellt. Nicht nur weil viele Tools entstehen die frei verfügbar sind, sondern auch weil viel Know How geteilt wird und die Community immer gerne bei Fragen hilft. Ein gutes Beispiel hier ist GitHub, eine code repository Tool wo Code, Algorithmen oder ganze Programme geteilt werden können. Dies birgt selbstverständlich auch gewisse Risiken, da bewusst Schadsoftware oder Schadcode eingeschleust werden kann.

Grundsätzlich kann gesagt werden, dass die heutigen verfügbaren Technologien die Recherche im Journalismus um ein Vielfaches erleichtern und auch nicht mehr wegzudenken sind. Diese “neue” Art der Datenbeschaffung birgt aber auch einige Risiken, vor allem auch im rechtlichen Bereich, zum Beispiel Thema “Data Privacy”. Es gibt viele Grauzonen und oft muss von Fall zu Fall mit Rechtsexperten die Sachlage genau geprüft werden.

Barnaby stellte dann eine weitere sehr interessante Story vor:

Die Story handelte davon, ob am Bundesgericht für Asylfragen in St. Gallen die 26 tätigen Richter “parteiblind” über die jeweiligen, ihnen zufällig, zugeteilten Asylgesuche entscheiden.

Über 30’000 Fälle seit 2006 wurden aus der öffentlich zugänglichen Datenbank ausgelesen und in Verbindung gestellt mit den ausgelesenen Daten der 26 Richtern. Der Fall zeigte eindeutige “Befangenheit” durch die Parteiwahl, rechtsorientierte Richter sagten öfters “Nein” zu Gesuchen, linksorientierte öfters “Ja”.

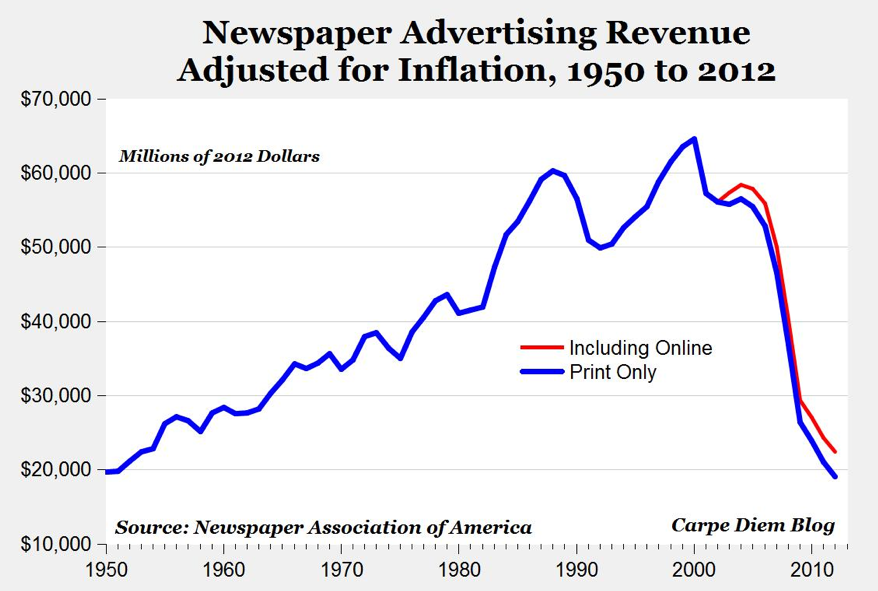

Der Journalismus bzw. die Zeitungsbranche war einer der Branchen, die sehr früh bereits stark “disrupted” worden ist durch neue digitale Innovationen wie zum Beispiel das Internet oder Smartphones. Auch war die Disruption so stark, dass sich in relativ kurzer Zeit gewisse Geschäftsfelder total untergingen. Noch immer herrscht ein Massensterben traditioneller Print-Zeitungen auf der ganzen Welt. Das grösste Problem sind nicht die schwindenden Leser oder Abonnenten, sondern die sehr schlechten Werbeeinnahmen durch “Print Ads” wie die folgende Statistik eindrücklich zeigt.

Wie man ebenfalls sieht, stehen die Einnahmen durch Online Ads in keinem Verhältnis, wie die Einnahmen vor 10 Jahren durch die Print Ads. Obwohl es bereits sehr viele Online Newspaper gibt, konnten die Einnahmen durch Werbung nie mehr nur annähernd an die guten Zeit um z.b. die Jahrtausendwende anknüpfen.

Der Konsum bzw. wie man an seine News kommt, hat sich durch diese Technologien ebenfalls stark verändert, der Einstieg zum einem Artikel kommt heute sehr oft aus dem “Sharen” auf einem der zahlreichen social media channel. Diese Art von Personalisierung kann zu starker Meinungsbildung führen und ist zur Zeit auch heftig in der Diskussion siehe z.b. Russian Meddling. Ebenfalls war es auch lange den traditionellen Journalisten vorbehalten News zu verbreiten und man hatte dadurch eine gewisse Sicherheit, dass die verbreitete News auch legitim ist. Heute kann jeder im Internet News verbreiten und dadurch ist die Gefahr von falschen Nachrichten auch um einiges höher als früher, Thema “Fake News“.

Zusammenfassend lässt sich sagen, dass die Art, wie Nachrichten und Stories entstehen, wo sie publiziert werden und wie sie konsumiert werden, sich in den letzten 50 Jahren grundlegend geändert hat, dadurch entstanden und entstehen neue Aufgabenbereiche, neues Business, neue Risiken usw. und auf der anderen Seite verschwinden auch viele Traditionen.

Was der Wandel sicherlich mit sich bringt sind die folgenden Punkte:

Viele Chancen und Potential stecken noch im Datenjournalismus, mit der sich stetig veränderten Technologie Landscape erwarten wir weitere spannende neue Möglichkeiten aus Daten Stories zu erschaffen

Z.b. folgende Opportunities stehen im Raum, Datenjournalismus als:

Unser Newsletter liefert dir brandaktuelle News, Insights aus unseren Studiengängen, inspirierende Tech- & Business-Events und spannende Job- und Projektausschreibungen, die die digitale Welt bewegen.